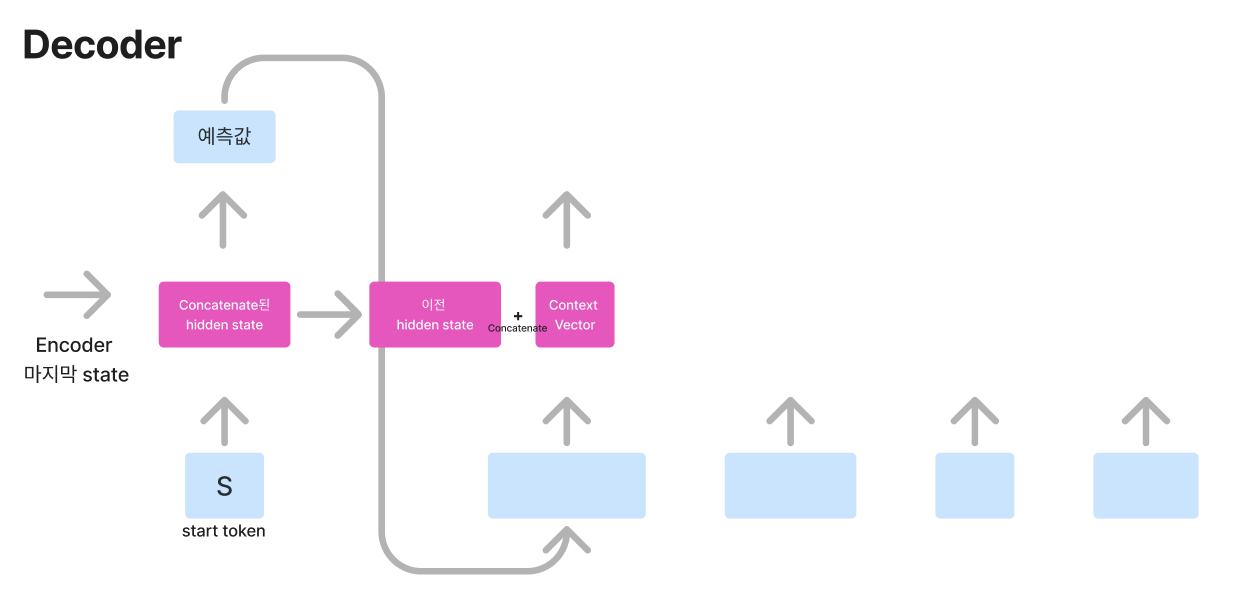

part 1에서는 image-text 관련 모델을 중점적으로 보았다면 이번 part에서는 video-text와 관련된 모델을 살펴보겠습니다.이번 글도 이준석 교수님 강의를 요약해 보았습니다.Video BERTVL-BERT와 비슷한 구조로 영상의 ASR(text) 데이터와 1.5초 간격으로 샘플링된 프레임을 입력으로 넣어줍니다.text가 아닌 뒷부분 데이터(영상)에 대해서 어떻게 학습할지 고민해야 됩니다.VL-Bert는 image를 object detection을 하여 하나하나 넣어줬습니다. 동영상의 경우 모든 프레임에 대해 object detection을 하기는 힘든데요. 그것을 해결하기 위해 Video tokenization을 합니다. 이는 프레임을 정확히 labeling 하는 것이 아닌 frame별로..