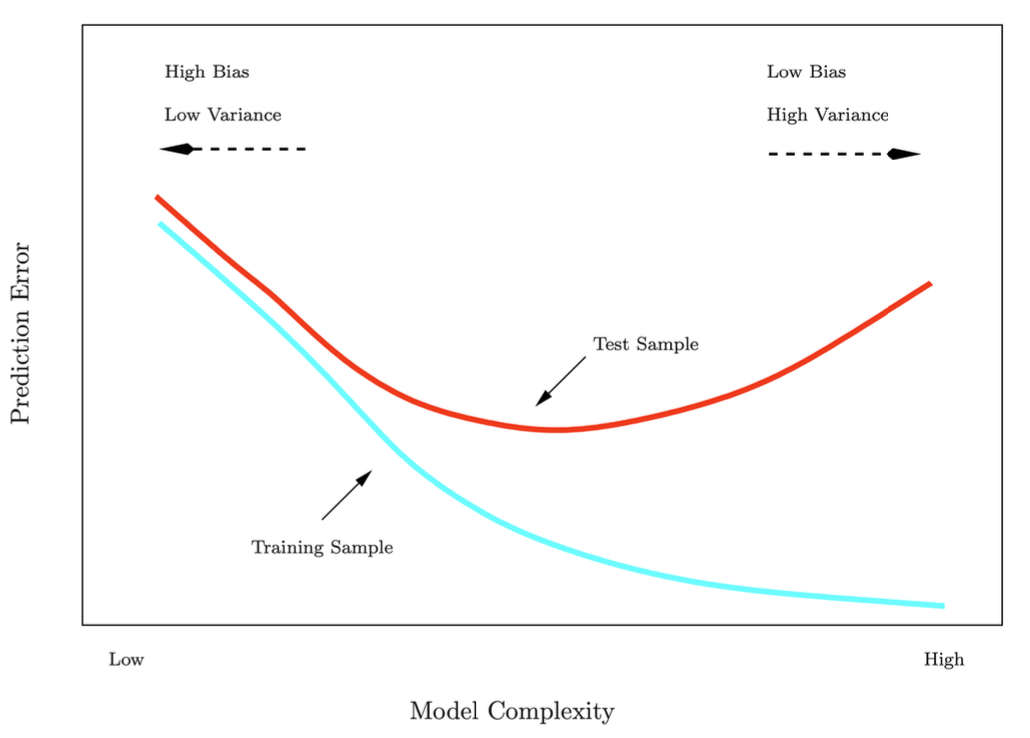

Shrinkage Methodsubset selection은 불필요한 feature를 제거하여 모델의 성능을 향상하지만, 자칫 필요한 변수까지 제거할 수도 있다.따라서 모든 feature를 이용하는 대신 regularization항을 추가하여 계수들이 0에 가깝도록 강제하는 Shrinkage Method에 대해 공부할 것이다. 대표적인 방법으로는 Ridge regression과 Lasso가 있다. Ridge regressionRidge regression은 다음과 같이 일반적인 선형 회귀 RSS에 계수들의 제곱합(l2 norm)에 대한 penalty term을 추가로 더하는 것이다.\(\lambda\)가 크면 \(\beta\)가 작아져 분산이 작아지지만 bias가 커질 수 있다.반면 \(\lambda\)..